Moreel zorgen of morele zorgen? Kunstmatige intelligentie, 'phronesis' en de uitholling van de zorgtaak

Lecturer in Philosophy

Dept. of Artificial Intelligence

Donders Centre for Cognition

Radboud University Nijmegen

Email: anco.peeters@donders.ru.nl

Kunstmatige intelligentie (KI) zou volgens voormalig zorgminister Fleur Agema een oplossing bieden voor de stijgende zorgkosten. Met behulp van KI kan men nieuwe medicijnen ontwikkelen, de behandelvoorkeuren van comapatiënten voorspellen, vragen van patiënten beantwoorden, en patiëntdossiers en -consulten samenvatten.

En dit is nog maar een kleine greep van de groeiende schare aan veronderstelde efficiëntieverbeterende mogelijkheden van generatieve KI, een doorsnede van de kunstmatige intelligentie die momenteel veel in de belangstelling staat vanwege de media-aandacht die ChatGPT – en haar moederbedrijf OpenAI – geniet. Met de mogelijkheden groeien ook de morele vraagstukken. Zo roept de Inspectie Gezondheidszorg en Jeugd zorgaanbieders op tot terughoudendheid met de inzet van generatieve KI, omdat er nog weinig bekend is over de specifieke risico’s ervan. Daarbij verwijst de IGJ expliciet naar de volgend jaar in werking tredende AI Act.[1] Kern van de AI Act is dat de mens centraal moet staan bij het implementeren van KI-systemen, dat die systemen betrouwbaar moeten zijn en uiteindelijk altijd een mens verantwoordelijk is voor de werking ervan. Deze aspecten zijn extra van belang bij het inzetten van KI in de zorg, waar mensen doorgaans extra kwetsbaar zijn.

Het valt op dat er bij deze en vergelijkbare discussies – over bijvoorbeeld de risico’s op misdiagnose door het trainen van KI-modellen met niet-representatieve data – vooral wordt nagedacht over hoe we goede regelgeving rondom KI-gebruik moeten opstellen om kwalijke gevolgen te voorkomen (Van Kolfschooten, 2021). Deze discussies laten zich goed begrijpen in termen van plichtsethiek (welke normen moeten er gelden?) of consequentialisme (welke handeling heeft de beste uitkomsten?). Echter, KI in de gezondheidszorg roept morele zorgen op die zich niet goed laat vatten in deze ethische begrippenkaders (Vallor 2011; Peeters 2024).

Hoe zit het met de invloed van generatieve KI op de taken en rollen die zorgverleners hebben? KI wordt vaak gebruikt om taken van mensen over te nemen. Maar het ondoordacht overhevelen van taken naar machines kan grote gevolgen hebben voor hoe zorgverleners hun werk beleven. Zo deelde een arts met mij haar zorg dat ze met een KI-systeem zal moeten werken dat verslag geeft van patiëntengesprekken.[2] Op papier zou dit haar tijd opleveren: ze hoeft niet meer zelf te schrijven, maar alleen nog een automatisch gemaakt verslag te controleren. Dit gaat efficiënter en maakt daarmee tijd vrij om meer patiënten te zien op een dag. Maar de arts wees erop dat de verslaggeving van een patiëntgesprek een moment van verwerking en reflectie is. Tijdens het opschrijven loopt ze door het gesprek heen: ¨Ben ik iets vergeten? Heb ik goed geluisterd?” Bij automatische verslaggeving en het zien van meer patiënten is er minder ruimte voor dit soort reflectie. Het zien van meer patiënten met minder verwerkingsmomenten zoekt bovendien een psychologische grens op bij de arts. Bij een discipline als kinderoncologie is het maar de vraag hoe mentaal gezond het is voor zorgverleners om sneller achter elkaar meer patiënten te spreken. Efficiëntiedenken bij het uitbesteden van zorgtaken, hoe begrijpelijk en soms noodzakelijk ook, riskeert daarmee het uit het oog verliezen van de menselijke maat in de zorg.

In wat volgt zal ik aandacht vragen voor morele zorgen die ontspringen uit de beperkingen die generatieve KI oplegt aan zorgverleners met betrekking tot hun welzijn en zelfontplooiing. Een belangrijke aanname hierbij is dat veel zorgverleners de zorg ingaan om andere mensen te helpen. Als we het daarom belangrijk vinden dat zorgverleners voldoening uit hun werk kunnen halen, moeten we bij het uitbesteden van zorgtaken stilstaan bij de impact daarvan op de rol van de zorgverlener. Met behulp van een aristotelische lens zal ik deze problematiek in kaart brengen en een oproep doen tot het vrijmaken van meer ruimte voor de praktische wijsheid – of phronesis – van zorgverleners.

Generatieve KI en zorgverlening

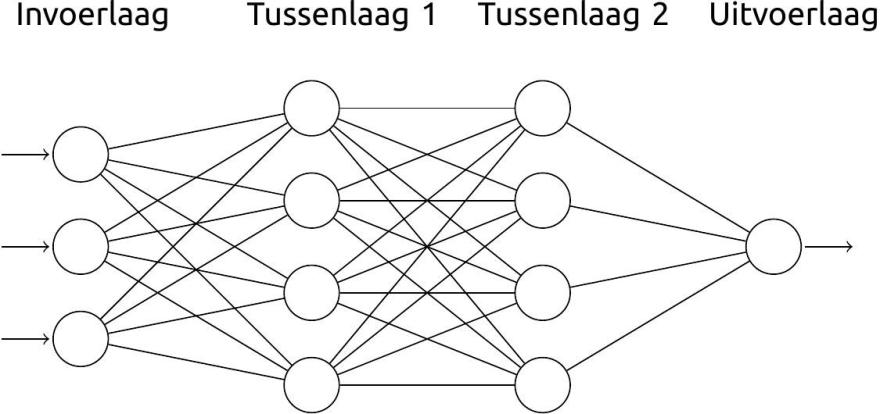

Grofweg omvat generatieve KI die systemen die het mogelijk maken om snel en gepersonaliseerd beeld, tekst, geluid en zelfs video te produceren (Bommasani e.a., 2021; Porsdam Mann, 2023). Het bekendste voorbeeld van zo’n systeem is ChatGPT (aangedreven door taalmodel GPT). GPT is een zogenaamd groot taalmodel (‘Large Language Model’) aangedreven door artificiële neurale netwerken, een categorie algoritmen dat al enkele decennia bestaat in de kunstmatige intelligentie. Deze neurale netwerken bestaan, analoog aan biologische neurale netwerken, uit knooppunten (de ‘neuronen’) en verbindingen en zijn uitstekend geschikt om bepaalde patronen in grote hoeveelheden data te ontdekken (zie Figuur 1 voor een simpel voorbeeld). Om bijvoorbeeld een taalmodel verbanden tussen woorden te leren kan men een artificieel neuraal netwerk enorm veel woorden in zinsverband voeren (aan de invoerlaag), totdat het netwerk geneigd is om bijvoorbeeld lidwoorden alleen aan zelfstandige naamwoorden te koppelen. Het creëren van deze verbanden gebeurt door het versterken van verbindingen tussen de knooppunten. Met name de knooppunten in de ‘tussenlagen’ van het model krijgen hierdoor bepaalde rollen toebedeeld (zoals het reageren op de woorden ‘de’ en ‘het’). Aan de uitvoerlaag komt dan een bepaald resultaat naar buiten rollen, zoals dat het netwerk de invoer als ‘Nederlands’ classificeert of niet.

Taalmodellen als GPT zijn Transformeernetwerken. Onderscheidend aan dit soort netwerken is het zogenaamde aandachtmechanisme, dat ze in staat stelt om contextgevoelig te reageren op sequenties van invoer, bijvoorbeeld door het woord ‘bank’ te koppelen aan financiële termen of aan meubels en andere huishoudelijke dingen. Dit mechanisme is in 2017 voorgesteld als efficiënte opvolger van netwerken die alle items in een sequentie achter elkaar proberen te verwerken.[3] Met de structuur van een transformeernetwerk zijn niet alleen op het oog goedlopende zinnen te construeren, maar is eigenlijk alles te generen wat opgeknipt kan worden in samenhangende sequenties, zoals opeenvolgende klanken die muziek vormen of afbeeldingen opgebouwd uit pixels. Het is belangrijk om te beseffen dat de verbanden die zo’n netwerk heeft geleerd puur statistisch van aard zijn. Als een ingevoerde tekst veel over financiën spreekt, dan zal het netwerk het woord ‘bank’ met een hogere waarschijnlijkheid associëren met woorden die met bankgebouwen samenhangen, dan met woorden die vaak met zitmeubels voorkomen. Achter dit wiskundig voorspellingsspel zit geen dieper begrip van de betekenis van de tekst.

Dat taalmodellen in beginsel statistische rekenmodellen zijn zonder besef van betekenis, laat onverlet dat ze op veel plekken ingang vinden. Zo kondigde het Universitair Medisch Centrum Groningen (UMCG) in een persbericht aan een generatief KI-systeem in te voeren dat op basis van patiëntgegevens vragen van patiënten beantwoordt.[4] Het UMCG geeft hierbij aan dat het KI-systeem tijd bespaart voor zorgverleners, die dan meer tijd voor patiënten zouden krijgen. Daarnaast zou het systeem niet alleen informatiever en uitgebreider antwoorden dan een zorgverlener, maar ook empathischer.[5]

Vanuit een plichtethisch perspectief kan men vragen stellen over hoe het zit met de menselijke waardigheid in deze interactie: wordt de mens als persoon serieus genomen wanneer zij antwoord krijgt van een machine? Een consequentialist kan zich afvragen of de tijdswinst die het systeem artsen oplevert, opweegt tegen de inherente onbetrouwbaarheid van een communicatiesysteem dat werkt met generatieve KI. Maar wat moeten artsen denken van een systeem dat wordt geïntroduceerd met als argument dat het meer empathischer zou zijn dan henzelf? Zijn artsen inderdaad minder empathisch dan een systeem dat tekst genereert op basis van kansberekening? Introduceren we met zo’n systeem niet juist het risico dat artsen nóg minder empathisch worden? Hen wordt immers de kans ontnomen om in dit soort interacties empathie te oefenen.

Deze vragen over de morele capaciteit van artsen laten zich slecht vangen in ethische kaders die hun aandacht richten op de intenties en uitkomsten van handelingen. De deugdethiek daarentegen is bij uitstek geschikt om, vanwege haar focus op hoe we optimaal kunnen functioneren, de morele druk die dit soort technologische ontwikkelingen plaatsen op de mogelijkheden die zorgverleners als professionals krijgen te kunnen duiden (Vallor 2021; Steen 2024).

Beknot generatieve KI zelfontplooiing?

Wat bedoel ik precies met het risico voor uithollen van zorgtaken? Dat heeft ermee te maken dat sommige taken – en zeker in de zorg – meer inhouden dan hun formele beschrijving. Dat wordt mooi geïllustreerd in het boek Practical Wisdom van Barry Schwartz en Kenneth Sharpe (2011, pp. 13-17), wanneer ze de werkzaamheden van ziekenhuisconciërge Luke bespreken.

In een gesprek met gedragswetenschappers vertelt Luke over de keer dat hij een aanvaring had met de vader van een comapatiënt. Luke had de kamer van de patiënt eerder die dag schoongemaakt, maar de vader, die al maandenlang aan het bed van zijn zoon zat, had dit niet gezien omdat hij even weg was gegaan. Iets later die dag kwam de vader verhaal halen bij de conciërge: waarom was de kamer niet schoongemaakt? In eerste instantie probeerde Luke zich te verdedigen door te zeggen dat hij dit al wél had gedaan en ging hij bijna de confrontatie aan, toen hij zich bedacht. Hij verontschuldigde zich en maakte de kamer (nogmaals) schoon, zodat de vader kon zien dat hij het deed. Luke legde vervolgens aan de gedragswetenschappers uit dat hij zich kon verplaatsen in de vader, die al zes maanden verdriet en frustratie ervaarde vanwege het lot van zijn zoon. Dat Luke de kamer nogmaals schoonmaakte had er niet mee te maken dat de kamer niet schoon was: hij zag in dat het voor de vader belangrijk was dat hij kon zien dat er goed voor zijn zoon werd gezorgd. In de taakomschrijving van Lukes baan als conciërge staan dingen als het verschonen van bedden, het dweilen van vloeren, het aanvullen van de wc-rollen en meer schoonmaaktaken. Er staat niets in over patiëntenzorg. Maar Luke werkt in een ziekenhuis en dit voorval laat zien dat, in Lukes opvatting althans, het zijn van een conciërge in een ziekenhuis iets anders is dan het zijn van een conciërge in, bijvoorbeeld, een advocatenkantoor.

Waar zit hem dat dan in? Van een conciërge in een kantoorgebouw zouden we bijvoorbeeld wel verwachten dat hij de weg zou wijzen naar iemand die een bepaald kantoor zoekt, maar we zouden Luke niet per se prijzen als hij op aandringen van een advocaat een kantoor nóg een keer schoonmaakt. In het beste geval is Luke dan conflictmijdend. Dat Luke in een zorginstelling werkt en daar omgaat met mensen die zich in een kwetsbare en hulpbehoevende positie bevinden maakt uit voor hoe we zijn handelingen waarderen. Ook voor Luke maakt het uit dat hij zich empathisch kan opstellen voor het leed van de vader uit het voorbeeld: dit motiveert hem om zorgzaam te zijn. Het geeft hem voldoening in zijn werk en, door deze kwaliteiten te ontwikkelen, groeit hij niet alleen als conciërge maar ook als persoon.

Menselijk welzijn en persoonlijke ontwikkeling zijn belangrijke morele kernwaarden in de deugdethiek. Persoonlijke ontwikkeling is hierbij belangrijk, omdat de deugdethiek goed en slecht duidt aan de hand van de vraag: “Hoe draagt wat ik doe bij aan wie ik wil zijn en worden als persoon?” Voor Aristoteles, die met zijn Ethica nicomachea doorgaans als de grondlegger van de deugdethiek in de Westerse filosofie wordt gezien, moet deze persoonlijke ontwikkeling gericht zijn op menselijk welzijn of geluk. Geluk in deze zin is de best mogelijke versie van jezelf worden, om uit te munten in wie je bent. In bovenstaand voorbeeld over Luke: het zijn van een conciërge die niet alleen goed schoonmaakt maar leert open te staan voor de emotionele behoeften van mensen in een zorginstelling.

Uitmunten, of het nu is als conciërge, arts, pianist of huisvader, is niet een proces dat op een gegeven moment voltooid is. En dan gaat het niet alleen om het krijgen van bijscholing om je kennisniveau op peil te houden. Om uit te munten, stelt Aristoteles, moet je blijven oefenen om belangrijke vaardigheden – zoals het empathisch vermogen om de emoties van anderen te delen, of het vermogen om op de juiste manier naar die behoeftes te handelen – scherp te houden. Het uitoefenen van empathie of andere vaardigheid is een blijvend proces van verbetering, omdat niet van tevoren is vast te leggen ‘hoeveel’ empathie in een bepaalde context genoeg is. De mate waarin een zorgverlener zich openstelt voor de emoties van een patiënt bij een slechtnieuwsgesprek kan afhangen van persoonlijke factoren bij de patiënt (zoals leeftijd), maar ook van hoe het gesprek zich ontwikkelt, de aard van het nieuws en de band tussen zorgverlener en zorgbehoevende. Bij een heftige emotionele reactie van de patiënt hopen we dat de zorgverlener meeleeft en zich niet compleet afsluit voor het verdriet. Maar het zou óók niet goed zijn als de zorgverlener – door persoonlijke ervaringen of omstandigheden – zo opgaat in de emoties van de patiënt, dat de hulpverlening eronder lijdt. Dit vinden van een balans tussen een tekort en een teveel is hoe Aristoteles ‘deugd’ definieert. Zo is het klassieke voorbeeld van dapperheid een midden tussen roekeloosheid (een teveel aan moed) en lafheid (een tekort). Beide extremen of ondeugden kunnen een soldaat onnodig in gevaar brengen. Empathie kan vergelijkbaar begrepen worden en KI-ethicus Shannon Vallor (2016) vat haar op als het midden tussen, aan de ene kant, het niet meeleven met anderen uit apathie of cynisme en, aan de andere kant, het teveel meeleven met anderen. In dat laatste geval ontstaat er een risico dat we onszelf gaan afsluiten voor andermans emoties. Vallor noemt dat soms psychologisch noodzakelijk en zelfs gerechtvaardigd, zoals wanneer iemand overweldigd dreigt te worden door het verdriet van een vriend. Tegelijk benadrukt ze dat veel mensen de neiging hebben hier selectief mee om te gaan door alleen in het geluk van anderen te willen delen en zich af te sluiten voor het lijden van anderen (p. 134). Dat is kwalijk omdat het begaan zijn met anderen, en dus ook met hun leed, ons kan aansporen tot het verlenen van steun en hulp, zoals we zagen bij de conciërge.

Is praktische wijsheid met generatieve KI mogelijk?

Omdat het cultiveren van deugden als empathie oefening vergt, moeten we ons dus bewust afvragen hoe de inzet van nieuwe technologieën ons kansen ontneemt (of geeft) om onze empathische vermogens te ontwikkelen. Vandaar dat het invoeren van het nieuwe door KI aangedreven communicatiesysteem in het UMCG zorgelijk is. Heeft men bijvoorbeeld nagedacht over of en hoe de afstand tot patiënten groter wordt gemaakt? Is er nog wel ruimte voor het oefenen en uitoefenen van empathische vermogens met het nieuwe systeem? Let wel: het punt is hier niet dat zo’n systeem empathie onmogelijk maakt. Het punt is dat er niet wordt stilgestaan bij hoe het overnemen van bepaalde taken door machines de menselijke interacties die nodig zijn voor het groeien als empathisch zorgverlener worden beknot. De vraag is vaak: “Hoe verwerken we sneller meer patiënten?” en niet: “Welke invloed heeft deze verandering op het welzijn van de zorgverlener?”

Om in te kunnen schatten of zorgprocessen worden uitgehold bij de invoering van nieuwe KI-systemen, is wat Aristoteles ‘praktische wijsheid’ (phronesis) noemt nodig. Praktische wijsheid is de gave om bij een deugd zoals empathie het juiste midden in een specifieke situatie te vinden (Aristoteles, EN. 1139–1145). Hoeveel empathie moet een psychiater tonen bij het behandelen van een patiënt met een persoonlijkheidsstoornis, wier hele bestaan afhangt van emotionele validering? Te weinig meeleven kan leiden tot negatieve gedachten bij de patiënt, terwijl te veel meeleven te sterke hechting kan aanmoedigen en overweldigend kan zijn voor de behandelaar (Pickard, 2011). Een psychiater die praktisch wijs is laat in dit scenario haar empathisch vermogen sturen door algemene kennis over de stoornis en door de ervaringen die ze in het verleden met deze en andere patiënten heeft opgedaan. Praktische wijsheid vereist dus kennis en ervaring. Precies hier werpt KI een barrière op. Vanwege de ondoorzichtigheid en onvoorspelbaarheid van veel KI-systemen weten we vaak niet welke uitwerkingen ze hebben (Peeters, in druk). Dat beperkt de praktische wijsheid die we kunnen uitoefenen. Om terug te grijpen op het voorbeeld in Groningen: we hebben gewoonweg de kennis (nog) niet om in te schatten of het langdurig verlaten op taalmodellen in patiëntcommunicatie de empathische vaardigheden van zorgverleners erodeert. Daarvoor is kennis nodig over de werking van het KI-model, de gangbare valkuilen bij gebruik ervan en inzicht in hoe mensen er in hun gebruik afhankelijk van kunnen worden. Tot het moment dat we deze kennis hebben – én er gebruikers ervaring mee hebben opgedaan – zijn er onvoorspelbare risico’s voor zorgverleners die deze systemen gebruiken.

Conclusie

Praktische wijsheid is op dit moment niet mogelijk met generatieve KI. Dat betekent dat we voorzichtig moeten zijn met het invoeren ervan op grote schaal. Daarnaast is het belangrijk om na te denken over hoe de implementatie van dit soort krachtige en in grote mate autonoom opererende systemen, de gewoonten van hun gebruikers (mis)vormt. Dat een schoonmaakrobot op papier de functieomschrijving van een conciërge kan invullen, betekent nog niet dat het een vervanging is voor de conciërge die – zich bewust van zijn werkomgeving – besluit van zijn werkschema af te wijken om iemand die troost nodig heeft te steunen. Welke stappen zouden er nodig zijn om het mogelijk te maken? Allereerst zal er meer onderzoek gedaan moeten worden naar de langdurige effecten op de vermogens van gebruikers van taalmodellen. In het onderwijs zijn hier al kleine stappen in gezet (Peeters, in druk). Verder zullen we gebruikers moeten scholen in de vaak onzichtbare risico’s van taalmodellen – zoals het feit dat zo’n model geen besef van betekenis heeft. Het allerbelangrijkste is echter om, in samenwerking met zorgverleners, in kaart te brengen hoe gebruik van generatieve KI de betekenis van het werk dat ze doen verandert.[6]

Literatuur

Aristoteles. Ethica Nicomachea (C. Hupperts & B. Poortman, Trans.). Damon, 2005.

Bommasani R et al. On the Opportunities and Risks of Foundation Models (Version 3). arXiv, 2021. https://doi.org/10.48550/ARXIV.2108.07258

Kolfschooten H van. Eerste stappen in Europese regulering van artificiële intelligentie: Algoritmes en patiëntenrechten. Tijdschrift Voor Gezondheidsrecht 2021; 45(4), 381–389. https://doi.org/10.5553/TvGR/016508742021045004008

Knoechel T-D et al. Core Principles of Responsible Generative AI Usage in Research. AI and Ethics 2025. Online first publication.

Kristjánsson K. Phronesis as an ideal in professional medical ethics: Some preliminary positionings and problematics. Theoretical Medicine and Bioethics 2015; 36(5), 299–320. https://doi.org/10.1007/s11017-015-9338-4

MacIntyre AC. After virtue: A study in moral theory (3e ed). University of Notre Dame Press, 1981/2007.

Peeters A. Out of control: Flourishing with carebots through embodied design. In G. Mecacci et al. (Eds.). Research Handbook on Meaningful Human Control over AI Systems (pp. 38–52). Edward Elgar, 2024. https://doi.org/10.4337/9781802204131.00010

Peeters A. (in druk). ChatGPT en de deugd van het denken: Een Aristotelische reflectie op generatieve KI in de klas. In L. van Elteren (Ed.). IK, AI: Over intelligente algoritmen en verantwoordelijkheid. Leusden: ISVW.

Pickard H. Responsibility Without Blame: Empathy and the Effective Treatment of Personality Disorder. Philosophy, Psychiatry, & Psychology 2011; 18(3), 209–224. https://doi.org/10.1353/ppp.2011.0032

Porsdam Mann S et al. Generative AI entails a credit–blame asymmetry. Nature Machine Intelligence 2023; 5(5), 472–475. https://doi.org/10.1038/s42256-023-00653-1

Sorin V et al. Large Language Models and Empathy: Systematic Review. Journal of Medical Internet Research 2024; 26, e52597. https://doi.org/10.2196/52597

Steen M. Ethische aspecten bij het ontwikkelen en toepassen van AI: Een methode voor reflectie en deliberatie. Justitiële Verkenningen 2024; 50(1), 109–126. https://doi.org/10.5553/JV/016758502024050001008

Svenaeus F. Empathy as a necessary condition of phronesis: A line of thought for medical ethics. Medicine, Health Care and Philosophy 2014; 17(2), 293–299. https://doi.org/10.1007/s11019-013-9487-z

Schwartz B & Sharpe K. Practical wisdom: The right way to do the right thing. Riverhead, 2011.

Tongeren, P. van. Leven is een kunst: Over morele ervaring, deugdethiek en levenskunst. Klement, 2016.

Vallor S. Carebots and Caregivers: Sustaining the Ethical Ideal of Care in the Twenty-First Century. Philosophy & Technology 2011; 24(3), 251–268. https://doi.org/10.1007/s13347-011-0015-x

Vallor S. Technology and the virtues: A philosophical guide to a future worth wanting. Oxford University Press, 2016.

Vallor S. Twenty-First-Century Virtue: Living Well with Emerging Technologies. In E. Ratti & T. A. Stapleford (Eds.). Science, Technology, and Virtues (pp. 77–96). Oxford University Press, 2021. https://doi.org/10.1093/oso/9780190081713.003.0005

Samenvatting

Maatschappelijke discussies over de invoering van generatieve kunstmatige intelligentie richten zich voornamelijk op duurzaamheid, regelgeving en datagebruik. Dit is zorgelijk omdat de invloed van KI op individueel menselijk welzijn grotendeels wordt genegeerd. Want wat moet ik als zorgverlener doen en vinden als mijn werkgever me aanmoedigt om patiëntvragen met behulp van KI te beantwoorden? Zulke vragen leggen morele zorgen over de verandering van de zorgpraktijk en de rol van zorgverleners bloot. Dit artikel laat zien hoe deugdethiek ons helpt reflecteren op deze zorgen en beargumenteert tevens dat we de nodige ‘praktische wijsheid’ (phronesis) missen om generatieve KI goed te gebruiken.

Trefwoorden: artificial intelligence; genAI; praktische wijsheid.

Summary

Societal discussions about the implementation of generative artificial intelligence focus mainly on sustainability, regulation and data use. This is worrying because the impact of AI on individual human well-being is largely ignored. What should I, as a healthcare provider, do and think if my employer encourages me to answer patient questions using AI? Such questions reveal moral concerns about changing healthcare practices and the role of healthcare providers. This article shows how virtue ethics helps us reflect on these concerns and furthermore argues that we lack the necessary “practical wisdom” (phronesis) to use generative AI in a moral way.

[1] “IGJ roept zorgaanbieders op om zorgvuldig om te gaan met generatieve AI” https://www.igj.nl/actueel/nieuws/2025/02/10/igj-roept-zorgaanbieders-op-om-zorgvuldig-om-te-gaan-met-generatieve-ai

[2] Tijdens het jaarcongres van de Vereniging voor Filosofie en Geneeskunde op 23 november 2024.

[3] Voor meer over de ontwikkeling van Transformernetwerken, zie: https://d2l.ai/chapter_attention-mechanisms-and-transformers/index.html of https://artint.info/3e/html/ArtInt3e.Ch8.S5.html

[4] Persbericht 13 november 2023: https://nieuws.umcg.nl/w/umcg-beantwoordt-vragen-pati%C3%ABnten-met-hulp-van-ai

[5] Dat het systeem meer empathisch zou overkomen is gebaseerd op onderzoek dat op het moment van het persbericht nog niet door het peer review proces was gekomen, maar inmiddels is gepubliceerd als Sorin e.a. (2024).

[6] Voor verdere onderzoek in deze richting zal het werk van MacIntyre (1981) over narratieven van belang zijn.